위클리 NLP

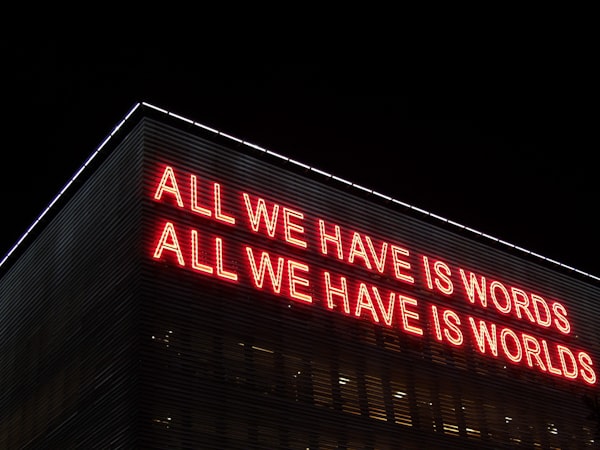

Week 23 - NLP의 궁예 등장? 관심법으로 번역을 잘해보자

2020년 봉준호 감독의 기생충이 아카데미를 수상하면서 함께 주목을 받았던 사람이 바로 그의 동시 통역가 샤론 최 씨인데요. 기계번역이 아무리 좋아도 당장은 이런 고퀄리티의 통역가는 대체될 수 없겠구나라고 할 정도로 훌륭한 실력을 선보였습니다. 저는 세 가지 부분에서 그녀의 통역이 굉장했다고 느꼈는데요: (1) 영화 업계 (충무로/할리우드)에서 쓰이는 전문 용어 (jargon)