인간처럼 생각하고 말할 수 있는 로봇은 항상 인류 기술 발전의 지향점 같이 여겨져 왔던 것 같습니다. 여러분은 한번 쯤은 어렸을 때 이러한 휴머노이드(humanoid)가 나오는 SF 영화를 본 적이 있지 않으신가요? 어떤 영화가 기억에 남으시나요? (이 답변에 따라 세대차이가 드러날지도 모르겠네요..)

전에도 언급한 적이 있지만 저는 <Her>와 <Ex Machina>을 가장 좋아합니다. 더 전으로 가면 스티븐 스필버그의 <A.I.> 또는 <Bicentennial Man> 등이 있겠고, 최근 세대는 <아이언맨>의 자비스를 떠올릴라나요.

GPT나 Meena 같은 챗봇 연구에 대해 함께 공부하면서, 딥러닝을 기반한 NLP 기술은 "이미 이러한 지향점에 도달한 것인가?"라는 질문이 자연스럽게 피어납니다.

우리의 기술은 현재 어디에 있는 것일까요? 이번 글에서는 이러한 질문에 대해 고민한 연구들을 살펴보도록 하겠습니다.

시의적절하게 NLP의 가장 대표적인 학회 ACL의 2020년의 주제(Theme)은:

Taking Stock of Where We’ve Been and Where We’re Going 이었습니다. 의역해보자면 "우리는 현재 어디에 있고 어디로 가는지 고민해봅시다" 정도가 되겠네요. 이 주제 연구 중에 Best Paper로 선정된 논문도 함께 살펴보겠습니다.

튜링 테스트, 중국어 방 실험 등 고전적인 연구부터 최근 1~2년에 사이 나온 연구도 소개하도록 하겠습니다.

AI/NLP 기술에 대한 연구지만 철학, 심리학, 생물학, 언어학, 신학 등 여러 가지 이야기가 섞여 있어 재밌기도 하지만 정말 한 가지 글로 정리하기가 어렵다고 느꼈습니다. 포괄적이지 못하더라도 주요 시사점을 커버하고 레퍼런스를 소개하는데 초점을 두도록 하겠습니다.

튜링 테스트 (THE TURING TEST)

Imitation Game으로 더 잘 알려진 튜링 테스트는 1950년 A.M Turing의 논문(Turing, 1950)에서 처음 제시됩니다. 이 논문의 첫 문장은 이렇게 시작합니다.

I PROPOSE to consider the question, ‘Can machines think?’

(나는 다음 질문에 대해 생각해보기로 제안한다, "기계는 생각할 수 있을까?")

튜링은 이 문제를 풀려면 "기계" 그리고 "생각"이 무엇인지 정의해야 하는데 이는 각각 엄청나게 어려운 문제이기 때문에 하나의 사고 실험(thought experiment)으로 대체하자고 제시합니다.

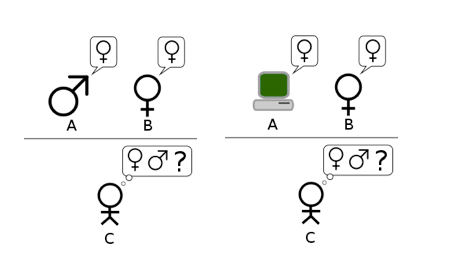

- 이미테이션 게임은 남성 1명 A, 여성 1명 B, 그리고 실험자 1명 C, 총 3명으로 구성됩니다.

- C는 A 또는 B일지도 모르는 사람 둘과 대화를 하면서 누가 남자이고 누가 여자인지 맞추어야 합니다.

- A와 B 중 한명은 실험자 C가 올바른 답변을 할 수 있도록 도와주는 것이 목표지만, 다른 한명을 C가 틀리는 것이 목표입니다. 한명은 최선을 다해 진실을 얘기할 것이고, 다른 한명은 머리를 굴려 속임수를 쓰고 있겠죠.

여기서 만약 A와 B 중 한명을 기계가 대신한다면?

사람이 했을 때보다 기계가 더 실험자 C를 잘 속일 수 있을까요?

튜링은 이 직관적인 게임을 "기계는 생각할 수 있을까?"라는 추상적이고 정의하고 어려운 질문을 대신하자고 제안하면서 그 유명한 튜링 테스트가 세상에 소개됩니다.

튜링은 50년 후(1950+50 = 2000년)에는 왠만한 실험자 C가 70% 이하의 확률로 틀릴 것이라고 예상합니다. 그리고 20세기의 끝 무렵에는 대부분 사람들은 "기계는 생각을 한다!"라는 말에 "뭐 당연한 얘기를 하고 있어.."라고 반응할 것이라고 예측합니다.

지금 돌아보자면 조금은 과하게 긍정적인 견해이긴 하지만, 현재 "알고리즘이 나를 여기로 이끌었다", "구글/알렉사한테 물어봐" 등의 이야기를 일상적으로 하는 것을 보면 완전히 틀렸다고 보기도 어렵지 않나 싶습니다. 정말 놀라운 것은 70년 전인 1950년에 이러한 예측을 할 수 있었다는 점이 아닐까요?

그리고 튜링은 논문의 나머지 지면을 "기계는 인간처럼 생각하는 것이 절대 불가능하다"라는 주장을 반박하는 것에 할애합니다.

"생각은 신이 인간에게 주신 고유한 능력임" 같은 신학적 관점,

"기계가 생각까지 하는 세상은 너무 끔찍해"라는 심리학적 관점,

"기계는 discrete-state machine이라 수학적으로 불가능해, 그에 반해 인간의 신경 시스템은 continuous machine임" 같은 수학+생물학적인 관점 등 여러 가지 주장을 하나하나 논의하면서 반박합니다.

자아(自我)라는 것은 존재하는 것일까?

잠깐, 근데 인간처럼 "생각"한다는 것은 무슨 의미일까요? "대화"를 잘하면 "생각"을 할 수 있는 것일까요? 아니면 자아(ego, consciousness) 또는 영혼(soul) 같은 인간만이 가진 특별한 무언가로부터 비롯되는 것이 "생각"일까요?

오늘 대화한 인간이 자아 또는 영혼을 가졌고, "생각"이라는 것을 했기 때문에 "대화"를 하였다고 확신할 수 있나요?

만약 그저 어떠한 알고리즘 또는 데이터에 기반해서 생성된 것이라면? 실제로 우리가 일상에서 내뱉는 많은 "말"은 "영혼"에서 나왔다기 보다는 사회적 알고리즘이나 메뉴얼에서 나오기도 합니다. "영혼 없는" 감사, "영혼 없는" 답변이라는 표현을 떠올리시면 무슨 말인지 알 수 있습니다. 튜링 역시 사람들은 서로 대화를 할 때 상대방이 "자아"나 "영혼"이 있다는 암묵적인 가정을 하는 것에 익숙해 있지만 실제로 깊게 생각해보면 단순한 문제가 아니라고 이야기합니다.

반대로 기계가 "자아"나 "영혼"이 없다고 증명하는 것도 같은 논리로 어렵습니다. 특히 최근 들어 GPT나 Meena 같이 대화를 어떤 인간보다 유창한 모델이 나온 이상, "대화"를 잘하는 것이 곧 자아나 영혼 같은 무언가가 있고, "생각"을 할 수 있다고 확신하기도 어려워졌습니다. 인간만 가진 이 무언가가 무엇인지 정확히 알 수 없기 때문에, 기계가 어느 순간 이 무언가를 가지게 되었는지 아닌지도 모른다는거죠.

중국어 방 실험 (CHINESE ROOM EXPERIMENT)

튜링 테스트를 반박하기 위해 (Searle, 1980)는 중국어 방 실험이라는 또 하나의 사고 실험을 제시합니다.

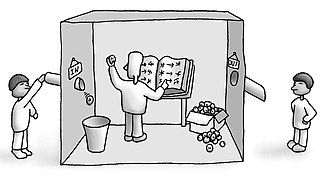

- 쪽지에 중국어로 된 메세지를 써서 방 안에 밀어 넣고, 다른 쪽에서 답변을 기다린다.

- 기다리는 사람은 방 안에는 무엇이 있는지 알 수 없지만, 사실은 무수하게 많은 중국어 책과 각종 질문을 답할 수 있는 표가 있다. 안에 있는 사람은 중국어를 전혀 이해하지 못하지만 그 책들과 표에 따라 답변을 적당히 골라 쪽지에 적어 건낸다.

이러한 사고 실험을 통해 존 설 교수는 튜링 테스트는 "기계는 생각할 수 있는가"라는 질문을 풀 수 있는 해답이 될 수 없다고 말합니다.

중국어 방 실험에서 방 안의 중국어 책과 표를 인터넷 데이터로, 방 안의 사람을 GPT 같은 딥러닝 모델로 대체해서 생각해본다면 어떨까요? 같은 논리로 딥러닝 모델은 중국어 또는 어떤 언어를 이해하고 있다고 보기 어렵습니다. 다만, 많은 데이터를 통해 사람의 언어에서 나타나는 패턴을 익히고 있을 뿐이죠.

BERT나 GPT는 세상에 대한 이해를 하지 못한다

Bender & Koller, 2020, Climbing towards NLU: On Meaning, Form, and Understanding in the Age of Data, 이 논문은 최근 BERT나 GPT는 세상에 대한 "이해"나 "의미"를 학습하고 있지 않다고 주장합니다.

이 주장의 핵심은 학습 데이터 형태에 있습니다. 우리는 언어에서 형태(form)과 의미(meaning)을 분리해서 생각해야 합니다.

- 형태(form): 언어가 다른 사람이 인식할 수 있는 무언가로 발현된 것(ex. 문자가 조합된 글, 음성으로 된 말, 몸짓으로 표현된 수화 등)

- 의미(meaning): 형태와 화자의 의사소통 동기(communicative intent)의 조합

여기서 커뮤니케이션 동기란 "이 사람이 왜 이 언어를 이 형태로 표출했는가?"로 이해할 수 있습니다. 예를 들어, 누가 "배고파"라고 말한다면 상황에 따라서는 자신의 영양 상태에 대해서만 얘기하는 것이 아니라 "무언가 먹을 것을 찾아줘" 같은 의지를 나타내는 것이겠죠.

핵심은 이러한 커뮤니케이션 동기는 언어보다 큰 복합적인 인간의 영역이라는 것입니다. 인터넷에서 "배고파"라는 텍스트를 수집했을 때는 그저 앞뒤에 있는 다른 텍스트가 전부이지만, 제가 "배고파"라는 말을 하였을 때는 위장에서 느끼는 화학적인 반응과 자취방의 냉장고를 열번 열어봤으나 도저히 이를 해소할 수 없다는 상황에서 나오는 간절함이 녹아져있겠지요.

언어 모델(Language Model; LM)이 많은 양의 텍스트 데이터만으로 세상을 이해할 수 있다고 주장하는 것은 마치 인간 아이에게 다른 것은 아무 것도 하지 않고 주구장창 테이프를 들려주기만 해서 언어를 습득할 수 있다고 하는 것과 같다고 합니다. (실제로 많은 아동 발달 연구를 통해 이는 불가능하다고 밝혀졌습니다. 언어와 함께 실제 물리적 세상과의 상호작용이 동반되어야 하죠.)

경험이 언어를 접지한다

(EXPERIENCE GROUNDS LANGUAGE)

"접지(grounding)"라는 표현은 아마 중학교 지구과학이나 물리 시간에 공부한 이후로 처음 들으셨을지도 모릅니다. 이는 전기 회로나 전자 기기를 땅에다 연결하는 방식을 말합니다. 예를 들어, 건물에 설치된 피뢰침이 번개를 맞으면 접지된 전극을 통해 엄청난 양의 전기를 지상으로 안전하게 흘려보냅니다.

이처럼 영어 표현에서는 "현실" 또는 "우리가 사는 세상"을 지상, 땅에 표현하는 경우가 많습니다.

"this person is really down-to-earth"

(직역: 이 사람은 정말 지구까지 내려와있어)

이런 표현은 이 사람이 이상적이기 보다는 매우 현실적이고 실용적이라고 할 때 쓰는 관용구입니다. 한국어에서도 비슷하게 "붕 뜨는 소리하지 말고 현실적인 대안을 내놔봐"라는 표현을 쓰기도 하지요.

NLP에서 grounding 역시 맥락에서 두루두루 쓰입니다. 현실 세계와 언어를 연결하는 부분을 일컫습니다.

EMNLP 2020에서 발표된 Bisk et al., 2020, Experience Grounds Language는 보기 드물게 각기 다른 분야/학교의 12명의 NLP 연구자들이 합동으로 쓴 논문인데요(벤지오 교수를 비롯해 한명한명 살펴보면 상당한 분들), Bender & Koller, 2020가 LM 문제의 증상들을 짚었다면, 이 논문은 좀 더 문제에 대한 정의에 집중하였습니다.

(Liz Im님께서 직접 이 논문의 한국어 번역/정리하신 자료를 공유해주셨습니다!)

Abstract에서 볼 수 있듯이, "현재 언어 이해 연구(Natural Language Understanding)는 실제 세상과 인간 간의 소통에 대한 이해가 빠져있다", "대형 언어모델이 놀라운 성과를 보여준 것은 맞지만, 커뮤니케이션은 상호간 형성된 실제 세상에 대한 공유 경험이 있어야만 한다"라고 합니다. 이게 무슨 말일까요?

우리가 다른 사람과 대화를 할 때 우리도 모르게 상대방도 보편적으로 같은 경험을 했을 것이라고 가정하는 것들이 굉장히 많습니다. 음식을 먹지 않으면 배고프다, 밤에는 잠을 자야 한다, 지구에는 중력이 있다, 고양이는 귀엽다, 누가 무기를 들고 오면 위협을 느낀다, 웃는다는 것은 행복함을 표현하는 것이다 등등등 나열할 수 없을만큼 무수히 많습니다.

다른 나라/문화권/세대의 사람과 대화를 했을 때 공감대가 적거나 말이 안 통하는 이유는 이러한 공유되는 보편적인 경험이 비교적 적기 때문입니다. 예를 들어, "보편적인" 한국인은 단일 민족/언어로 구성된 사회에서 살아왔기 때문에, 미국 같이 다양한 민족/인종/언어의 사회에서 통용되는 가치, 언어, 사회적 아젠다에 공감하지 못할 확률이 높습니다. 옳고그름을 떠나서 여태까지 살아온 경험이 너무나 다르기 때문이죠.

이를 우리는 "세계관(world scope, worldview)"라고도 합니다.

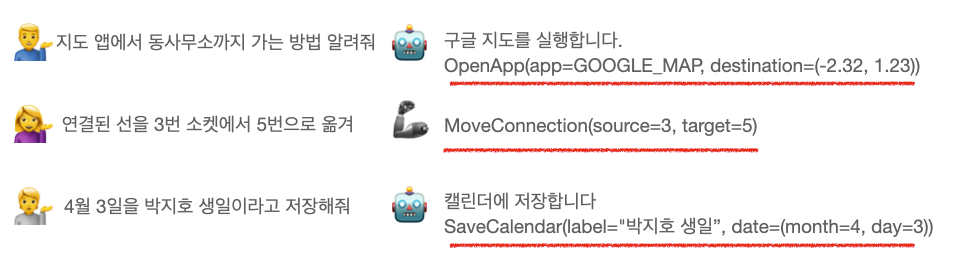

그렇다면 AI 모델은 어떤 세계관을 가지고 있을까요? Bisk et al., 2020에서 우리가 학습시키고 있는 세계관을 5개의 레벨로 정의하였습니다.

WS1. 코퍼스 (corpus)

WS2. 인터넷 (Web)

WS3. 인지 (Perception)

WS4. 체현 (Embodiment)

WS5. 사회 (Social)

WS1. 코퍼스 (corpus)

코퍼스는 NLP 모델에게 주어지는 데이터를 뜻합니다. 전에는 인터넷이 발달하지 않았기 때문에 엄청난 양의 데이터를 수집할 수가 없었습니다. 어떠한 주제는 아직도 이러한 한계점을 가지고 있고요. WS1 모델은 오직 (비교적) 작은 양의 데이터만 보기 때문에 일반화(Generalization) 성능이 떨어질 수 밖에 없습니다.

WS2. 인터넷 (Web)

현재 BERT와 GPT는 인터넷에서 크롤링된 엄청난 양의 텍스트 데이터를 통해 학습되었습니다. 그리고 이런 모델들을 Pretrained 모델로 사용해서 더 작은 양의 데이터로도 좋은 일반화 성능에 도달할 수 있죠. 현재 우리는 대체로 이 레벨에 있습니다.

WS3. 인지 (Perception)

하지만 여태까지 말해왔듯이 텍스트만의 한계는 분명해보입니다. 인간은 글을 읽는 것 외에, 눈으로도 보고, 귀로도 듣고, 피부로 느끼고, 혀로 맛을 보고, 코로 냄새를 맡습니다. 이러한 오감이 우리의 언어에 지대한 영향을 끼칩니다. "달콤쌉사름하다", "몽실몽실하다" 같은 단어 뿐만 아니라 단순히 "시원하다", "덥다" 같은 단어를 AI는 진정으로 이해하지 못합니다. 왜냐하면 이 언어들과 연결된 다른 인지 데이터가 없기 때문이죠.

최근 많은 AI 연구들이 인지와 언어가 조합된 데이터를 이용하는 방향으로 가고 있습니다. 이를 Multi-modal이라고 하는데요. 가장 발전이 많은 분야는 역시 Computer Vision + Language입니다. 아무래도 이미지가 데이터를 수집하기가 수월하기 때문에 그렇지 않을까 싶은데요. 더 많은 조합 또는 오감이 전부 조합된 데이터가 더 나올 수 있을까요?

WS4. 체현 (Embodiment)

더 폭넓은 인지 데이터가 가능해진다면 다음 레벨은 이에 대한 어떤 액션을 취하는 것일 겁니다. 인간 아기는 이것저것 만져보고, 뭐든 입에도 넣어보고, 방방 뛰기도 하면서 자신의 액션을 통해 세상과 소통하며 다양한 피드백 받습니다. 이는 자신이 컨트롤할 수 있는 몸이 있기 때문이죠.

로보틱스와 강화학습(reinforcement learning)의 결합이 이러한 세계관을 확립하기 위한 시도라고 볼 수 있겠습니다. 물론 아직은 해결해야 할 문제가 많아보입니다.

WS5. 사회 (Social)

인간이 속해있는 궁극적인 세계관입니다. 우리가 언어를 사용하는 것은 우리가 어느 사회적 관계에 속해있기 때문입니다. 좁게는 친구, 가족, 회사 뿐만 아니라 인터넷 같은 가상 공간에서 우리의 사회적 상호작용이 이어집니다. 우리가 말이든 글을 내뱉는 많은 이유는 우리가 속해있는 사회에 어떤 작용을 하기 위해서 입니다. 감정 표현이든, 정보 공유이든 간에 내가 속한 사회에 누군가가 나에게 어떤 피드백을 주는 것을 바라기에 인간은 언어적 활동을 한다는 것이죠.

인간 아기는 어렸을 때부터 이러한 세계관을 형성합니다. 배고프면 울고, 배설을 하면 울고, 안아주면 멈추고, 기분 좋으면 웃고.

AI 모델에게 이러한 사회적 상호작용을 이해시킬 수 있는 데이터를 만들 수 있을까요?

논문에서는 이러한 데이터를 구축하는 것은 거의 불가능에 가깝지 않을까라는 말을 합니다. 지금 NLP 데이터를 수집할 때도 다양한 사회적 컨텍스트(ex. 성별, 소득 수준, 연령, 문화 등)가 무시되고는 합니다. 특히 크라워드소싱을 통한 데이터 수집에서는 수십~수천 명의 사람이 작업을 하는데, 각각이 가진 사회적 컨텍스트는 직접적으로 반영되지 않거나 간접적으로 반영되지만 다수결이라는 방식에 섞여 버리고는 합니다.

1950년 튜링 박사가 제시한 문제 "기계는 생각할 수 있을까?"는 70년 후 아직까지도 우리에게 아주 중요하지만 풀리지 않은 문제로 남아있습니다. NLP 연구자들이 최근 몇 년 간 엄청나게 좋은 성능을 통해 많은 관심을 받은 모델들에 대해 리뷰하면서, "우린 아직 갈 길이 멀어"라고 이야기하는 것이 매우 인상 깊었습니다. 아무래도 1970~90년대에 AI에 대한 관심이 올라갔다가 훅 떨어진 AI Winter를 경험해서 그런지 GPT에 대한 Hype을 신중하게 다루고 있다는 생각을 하기도 하였습니다.

쉽지 않은 주제라 논문을 읽고 글을 쓰는데 꽤 오랜 시간이 걸렸지만 정리하여 다 쓰고 나니 정말 뿌듯합니다. 개인적으로는 직접 이 논문들을 읽어보시는 것을 추천드립니다. 지금 NLP 연구를 하고 계시는 대학원생이나 연구원 분들께 굉장한 많은 도움이 되지 않을까 싶습니다. (많은 생각과 고민도 덤!) 특히 Bisk et al., 2020은 인용 페이지가 무려 9페이지나 되는 알찬 Survey 논문이기도 합니다.

Reference

- Emily M Bender and Alexander Koller. 2020. Climb- ing towards nlu: On meaning, form, and understand- ing in the age of data. In Association for Computa- tional Linguistics (ACL).

- Yonatan Bisk, Ari Holtzman, Jesse Thomason, Jacob Andreas, Yoshua Bengio, Joyce Chai, MirellaLapata, Angeliki Lazaridou, Jonathan May, Aleksandr Nisnevich, et al. Experience grounds language, EMNLP 2020

- Searle, John (1980), "Minds, Brains and Programs", Behavioral and Brain Sciences,

- Turing, Alan (October 1950), "Computing Machinery and Intelligence", Mind,